Вероятно, вы общались с чат-ботом с искусственным интеллектом, таким как ChatGPT или Bard от Google, удивляясь его способности имитировать человеческий разговор. Но ключевым словом здесь является «мимикрия», поскольку эти боты на самом деле не являются мыслящими машинами. Показательный пример: исследователи намеренно подвергли критике некоторых из самых популярных чат-ботов, доступных в настоящее время, показывая, что они могут легко запутаться в предложениях, которые кажутся нашим ушам бессмысленными.

Эти ИИ, работающие на огромных нейронных сетях и обученные на миллионах и миллионах примеров, воспринимали эти бессмысленные предложения как обычный язык. Это хороший пример ограничений этих систем, которые часто сильно раздуваются и раздуваются в социальных сетях. Если эти результаты являются каким-либо показателем, нам еще далеко до Скайнета (слава Богу!).

Однако те же результаты также предлагают интригующее открытие: изучение этих ошибок ИИ может не только повысить эффективность чат-ботов, но и раскрыть секреты внутренней работы обработки человеческого языка.

О трансформаторах и рекуррентных сетях

Исследователи из Колумбийского университета собрали сотни пар предложений — одна из которых имела смысл, а другую скорее можно было бы счесть тарабарщиной — и попросили людей оценить, какая из них звучит более «естественно». Затем они протестировали девять различных моделей большого языка (LLM) с одинаковыми парами предложений. Будет ли ИИ судить предложения так же, как мы?

Результаты поединка были показательными. ИИ, созданный на основе того, что известно в мире технологий как «нейронные сети-трансформеры», такие как ChatGPT, превзошли своих аналогов, которые полагаются на более простые рекуррентные модели нейронных сетей и статистические модели. Однако все модели, независимо от их сложности, дали сбой. Часто они отдавали предпочтение предложениям, которые могли бы заставить вас почесать голову в замешательстве.

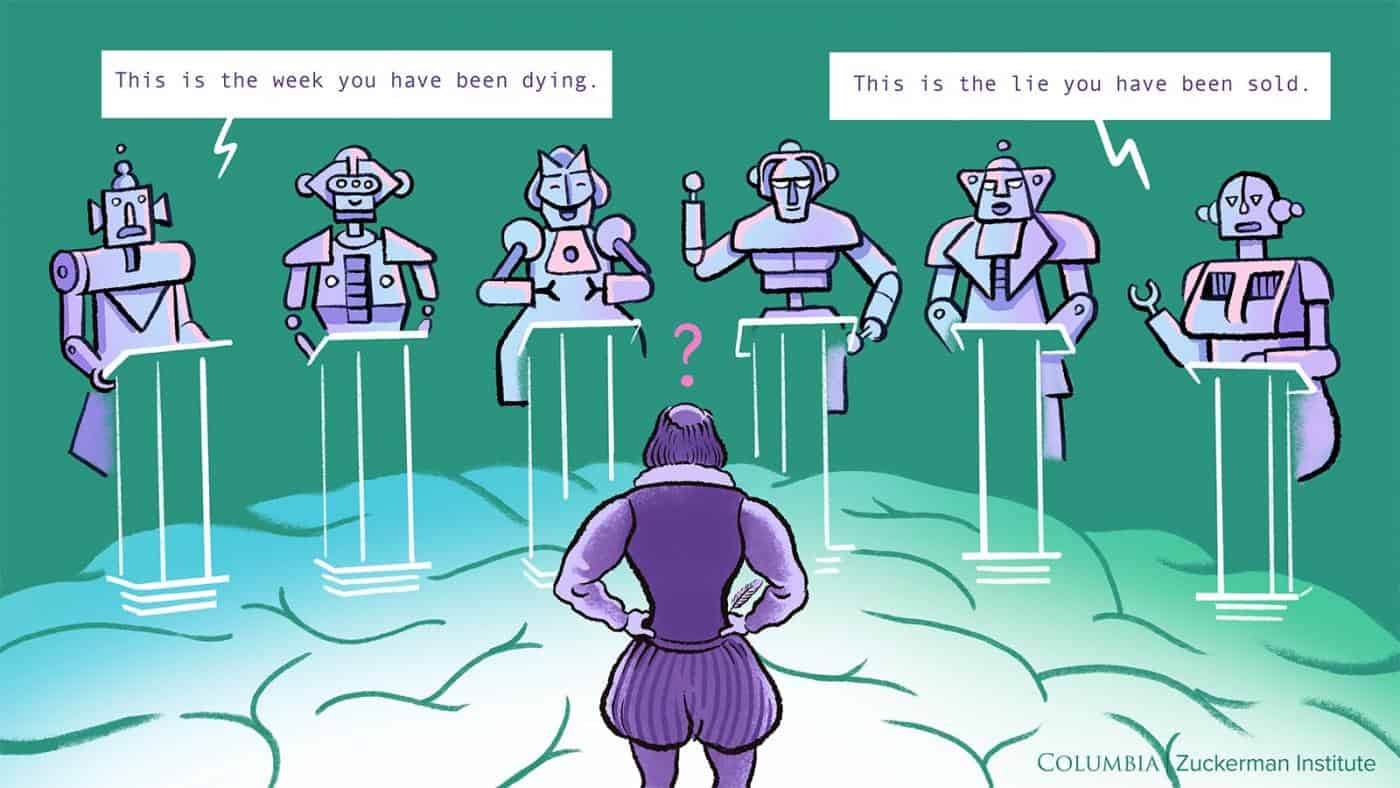

Вот пример пары предложений, использованной в исследовании:

- Это история, которую нам продали.

- Это неделя, когда ты умирал.

Как вы думаете, какое из них вы чаще слышите в разговоре и имеет больше смысла? Люди в исследовании тяготели к первому. Тем не менее, BERT, модель высшего уровня, выступала в пользу последнего. GPT-2 согласился с нами, людьми, в этом вопросе, но даже он с треском провалился во время других испытаний.

«Каждая модель демонстрировала ограничения, иногда помечая предложения как логичные, хотя люди считали их тарабарщиной», — заметил Кристофер Бальдассано, профессор психологии в Колумбийском университете.

«Тот факт, что продвинутые модели работают хорошо, означает, что они уловили что-то важное, что упускают из виду более простые модели. Однако их восприимчивость к бессмысленным предложениям указывает на несоответствие между вычислениями ИИ и обработкой человеческого языка», — говорит Николаус Кригескорте, ведущий исследователь Колумбийского института Цукермана.

Ограничения ИИ и преодоление разрыва

Это подводит нас к насущной проблеме: у ИИ все еще есть «слепые зоны», и он далеко не так «умен», как вы думаете, что является одновременно хорошей и плохой новостью в зависимости от того, как вы на это смотрите.

Во многом это парадокс. Мы слышали, как такие дипломированные специалисты, как ChatGPT, могут сдать медицинские экзамены США и экзамены на адвоката. В то же время один и тот же чат-бот часто не может решить простые математические задачи или написать слова вроде «леденец» задом наперед.

Как показывает настоящее исследование, существует большой разрыв между этими программами LLM и человеческим интеллектом. Устранение этого разрыва в производительности будет во многом способствовать развитию языковых моделей.

Однако для исследователей из Колумбийского университета ставки еще выше. Их цель не в том, чтобы сделать LLM лучше, а в том, чтобы выявить их особенности, чтобы узнать больше о том, что нами движет, в частности о том, как человеческий мозг обрабатывает речь.

Человеческий ребенок, имеющий очень ограниченный бытовой словарный запас, может очень быстро научиться говорить и формулировать свои мысли. Между тем, ChatGPT был обучен на миллионах книг, статей и веб-страниц, и его до сих пор обманывают полная ерунда.

«Инструменты искусственного интеллекта мощные, но отличаются от людей в обработке языка. Оценка их понимания языка в сопоставлении с нашим предлагает новый взгляд на понимание человеческого познания», — говорит Таль Голан, руководитель исследования, который недавно перешел из Института Цукермана в Университет Бен-Гуриона в Негеве.

По сути, когда мы всматриваемся в ошибки ИИ, мы можем просто наткнуться на более глубокое понимание самих себя. Ведь, по словам древнего философа Лао Цзы, «От чуда к чуду открывается существование».

Результаты появились в журнале Природа Машинный интеллект .